Introduction

Les entreprises comptent davantage sur leur aptitude à concevoir et exploiter des systèmes logiciels pour arriver à leurs objectifs. Pour examiner leurs performances, elles ont besoin d'un moyen de mesurer l'efficience de leurs pratiques de livraison. Nous allons dans cette partie vérifier comment le rapport DORA mesure ces performances.

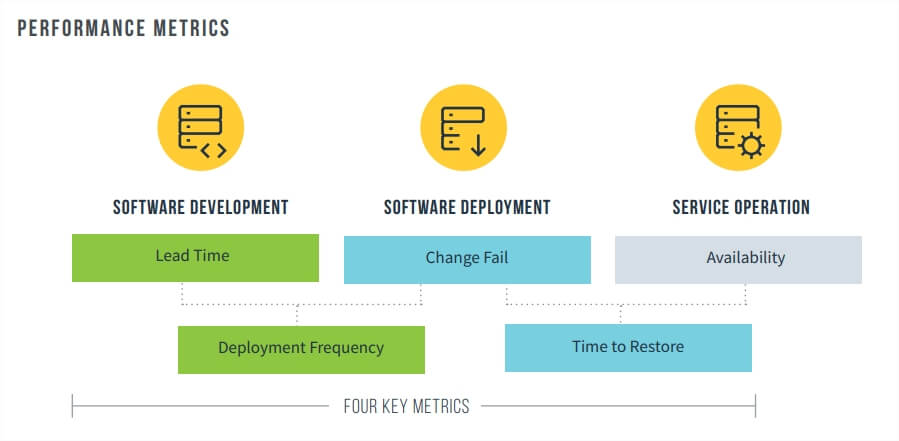

Les métriques de performances

Pour cela, le rapport au cours de ces six dernières années a mentionné et validé cinq mesures de performance de livraison qui fournissent une vue globale des processus de livraison.

Les cinq métriques de performances de livraison

Les métriques de la vitesse et de la stabilité

Les quatre premières mesures qui capturent l'efficacité du processus de développement et de livraison peuvent être résumées en matière de vitesse et de stabilité :

- Vitesse: mesurée en utilisant le délai de livraison, soit le délai entre le code validé et sa mise en production. Ainsi que la fréquence quotidienne de déploiement.

- Stabilité: mesurée en utilisant le temps de restauration, soit le temps nécessaire pour détecter et corriger un incident impactant les utilisateurs finaux. Mais également, le pourcentage du taux d'échec qui mesure la qualité du processus de publication.

Les métriques de la disponibilité

La cinquième métrique de performance concerne la disponibilité qui reste importante pour mesurer l’efficacité opérationnelle d’une infrastructure. Elle consiste à affirmer qu’un service est disponible et accessible par les utilisateurs finaux. La disponibilité indique également la façon dont les équipes déterminent et suivent leurs objectifs de disponibilité et tirent des leçons de toute interruption.

Classement par métriques de performances

Le rapport classe les performances de livraison de logiciels sous forme de quatre catégories :

- Élite

- Élevé (High)

- Moyen (Medium)

- Faible (Low)

Le tableau ci-dessous dévoile les questions posées aux candidats et comment ils les ont classés par niveaux de performances :

| Niveaux de performances de livraison de logiciels | Élite | Élevé | Moyen | Faible |

|---|---|---|---|---|

|

Fréquence de déploiement "Pour l'application ou le service principal sur lequel vous travaillez, à quelle fréquence votre organisation déploie-t-elle du code en production ?" |

À la demande (plusieurs déploiements par jour | Entre une fois par jour et une fois par semaine | Entre une fois par semaine et une fois par mois | Entre une fois par mois et une fois tous les six mois |

|

Délai de livraison "Pour l'application ou le service principal sur lequel vous travaillez, quel est votre délai de modification (c'est-à-dire combien de temps faut-il pour passer du code validé au code exécuté avec succès en production) ?" |

Moins d'une journée |

Entre un jour et une semaine |

Entre une semaine et un mois |

Entre un mois et six mois |

|

Restauration du service "Pour l'application ou le service principal sur lequel vous travaillez, combien de temps faut-il généralement pour restaurer le service lorsqu'un incident de service ou un défaut qui affecte les utilisateurs se produit ?" |

Moins d'une heure | Moins d'une journée | Moins d'une journée | Entre une semaine et un mois |

|

Taux d'échec "Pour l'application ou le service principal sur lequel vous travaillez, quel est le pourcentage des modifications apportées à la production qui entraînent une dégradation du service et nécessite par la suite une correction ?" |

0-15% | 0-15% | 0-15% | 46-60% |

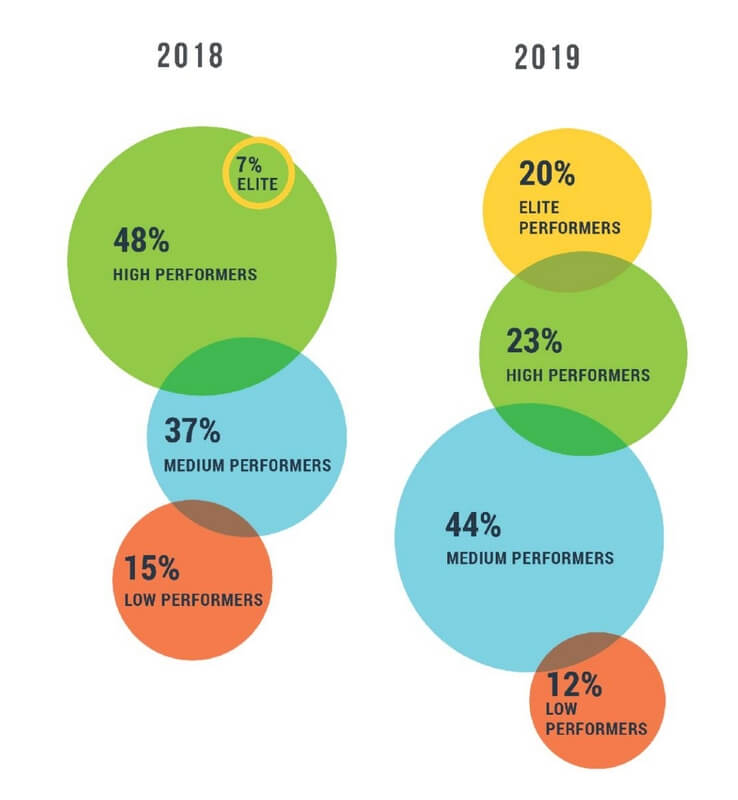

Année 2018 vs 2019

Ils ont ensuite comparé les proportions de chaque cluster de performance entre l’année 2018 et 2019 :

Pourcentage de niveau de performances année 2018 vs 2019

Les performances d'élite ont été identifié pour la première fois dans le rapport de l'année 2018, mais ce groupe était un sous-ensemble d’acteurs des plus performants. Cette année en revanche, il existe quatre groupes distincts dans leur analyse. Cette comparaison nous montre que :

- La proportion des acteurs d'élite a presque triplé, ce qui montre que l'excellence est possible, elle nécessite simplement une exécution.

- La proportion d’acteurs peu performants est en baisse. Cela reflète un changement continu dans l'industrie.

- La proportion d’acteurs moyennement performants est en hausse. Certains sont probablement montés de grade, tandis que d'autres peuvent avoir chuté.

Comparaison des métriques par niveaux de performances

Fréquence de déploiement

Conformément aux dernières années, le groupe d'élite a indiqué qu'il déploie régulièrement à la demande et effectue plusieurs déploiements par jour. Au rythme normal, les organisations d'élite ont effectué au moins 1460 déploiements par an (au rythme de 4 par jour), tandis que les moins performants n'en ont fait que 7 par an. L'extension de cette analyse montre que les acteurs d'élite déploient leur code 208 fois plus fréquemment que les artistes peu performants.

Il convient de noter que quatre déploiements par jour est une estimation, car des sociétés telles que CapitalOne déclarent déployer jusqu'à 50 fois par jour pour un produit, et des sociétés comme Amazon, Google et Netflix déclarent déployer des milliers de fois par jour sur les centaines de services qui composent leurs environnements de production.

Délai de livraison

De même, les organisations d'élite signalent des délais de livraison de moins d'un jour, le délai de modification étant mesuré comme le temps écoulé entre le code engagé et le déploiement réussi de ce code en production.

Les élites performantes ont signalé des délais de modification inférieurs à une heure. Inversement, les acteurs faiblement performants ont nécessité des délais de réalisation compris entre un mois et six mois. Le rapport a noté qu’en moyenne, le groupe élite a des délais de livraison 106 fois plus rapides que ceux des peu performants.

Restauration de service

Ensuite, le groupe d'élite a annoncé qu'il rétablissait son service en moins d'une heure, tandis que les groupes peu performants ont indiqué une restauration entre une semaine et un mois. Soit en moyenne d’une heure pour les plus performants et d’une semaine (168 heures) pour les moyens performants et d'un mois (5 040 heures) pour les moins performants.

Sur la base de ces chiffres, les acteurs élites affichent un temps de restauration 2 604 fois plus rapide par rapport aux moins performants. Cependant, le temps de restauration des services est resté le même pour l'élite et les moins performants par rapport à l'année précédente.

Taux d'échec

Les acteurs d'élite ont signalé un taux d'échec compris entre 0% et 15%, tandis que les acteurs peu performants ont déclaré des taux d'échec entre 46% à 60%. La moyenne entre ces deux plages montre un taux d'échec de 7,5% pour les organisations d'élite et de 53% pour les organisations peu performantes.

Cela représente des taux d'échec pour les élites qui sont 7 fois meilleurs que pour les acteurs peu performants. Cependant, les taux d'échec sont restés les mêmes pour l'élite et les peu performants par rapport à l'année précédente.

Disponibilité

Le rapport a également témoigné l'an précédent la conclusion selon laquelle une meilleure livraison de logiciels va de pair avec une disponibilité plus élevée.

Leur analyse montre également que les mesures de disponibilité sont corrélées de manière révélatrice avec les profils de performance. En effet, les acteurs élites et hautement performants ont systématiquement exprimé une disponibilité efficace. Les acteurs élites étant d’après eux 1,7 fois plus susceptibles d'avoir de meilleures pratiques de disponibilité.

Taille de l’organisation et performance

Le rapport avait effectué des analyses supplémentaires pour vérifier si la taille de l'industrie et de l'organisation avait un effet significatif sur le niveau de performance.

Ils ont observé que les grandes entreprises avec un effectif de plus de 5 000 employés, restent moins performants que celles de moins de 5 000 employés. D’après leurs observations, cela est éventuellement dû à plusieurs éléments remarqués dans les grandes organisations, notamment les processus et les approbations lourdes ainsi que les architectures étroitement couplées et mutualisées qui introduisent des instabilités et retards de livraison.

Cependant, ils encouragent les entreprises à ne pas prendre ces conclusions comme une excuse pour justifier une mauvaise performance, mais de bien reconnaître que l'excellence est possible. Ils doivent se lancer dans un programme d'amélioration continue et se tourner vers d'autres grandes entreprises qui ont atteint des performances d'élite et profiter de leur inspiration et leurs judicieux conseils.

Conclusion

Voici comment le rapport DORA parvient à mesurer le niveau d'excellence DevOps des entreprises grâce aux cinq mesures de performance de livraison citées auparavant.

Et vous dans tout ça, dans quelle catégorie se situe votre entreprise: élite, élevé, moyen, faible 🙂 ?

@guy-colin

@thierry-valette

@coulon-aimee

@nathalie-lemaitre

@monique-picard

@catherine-pruvost